迁移学习(transfer learning)正在改变AI开发方式,新手利用迁移学习可节省数据资源、加速原型迭代,即便仅有少量样本也能优化模型效果。文章详细介绍迁移学习基础、主流方法、实操流程和工具平台,辅以误区解析、常见Q&A和未来展望,帮助AI初学者0到1掌握迁移学习理论与实战。

迁移学习(Transfer Learning)为何成为AI领域新宠?

随着人工智能(AI)模型规模日益庞大,数据和计算成本不断攀升,让AI开发变得越来越依赖资源。迁移学习(Transfer Learning)以其“站在巨人肩膀上”的思路,通过复用已有模型知识,极大降低了新任务下开发难度。本篇将全面揭秘新手小白如何快速用迁移学习优化AI模型表现,助力你的AI实践之路!

迁移学习基础科普

什么是迁移学习?

迁移学习(Transfer Learning)指将针对某一任务或数据集已训练好的模型参数和知识,迁移、应用到新任务上,从而加快新模型的训练、减少数据需求并提升表现。例如利用ImageNet上训练的ResNet,轻松应用到医学影像等小数据场景。

为什么要用迁移学习?

- 显著节省数据与计算资源(无需自训练大模型)

- 更快迭代产品原型,缩短研发周期

- 小数据集表现优秀,适合冷门或数据稀缺任务

AI产业主流迁移学习场景

| 典型项目 | 益处 | 适合人群 |

|---|---|---|

| 图像分类 | 复用大模型特征 | 数据工程师、开发者 |

| 文本情感分析 | 微调NLP大模型 | 内容审核、产品初学者 |

| 声音/视频识别 | 跨模态迁移 | 媒体AI工程师、新媒体人 |

迁移学习主要方法及新手实现流程

迁移学习的主流技术路线

微调(Fine-tuning)

- 定义:保留预训练大部分权重,仅输出头等部分参数训练。

- 应用:如将ResNet应用于新医疗场景。

- 操作易度:PyTorch、TensorFlow已集成API。

特征提取(Feature Extraction)

- 定义:冻结绝大多数层,仅提取输出特征,用SVM等完成分类。

- 适合数据极小或算力有限场景

迁移学习框架对比及推荐

| 模型/平台 | 迁移方式 | 社区成熟度/推荐 | 官方入口 |

|---|---|---|---|

| TensorFlow/Keras | 特征提取/微调 | API友好、案例多 | 官方教程 |

| PyTorch | 特征提取/微调 | 适合实验 | 官方文档 |

| HuggingFace | 微调NLP | 整合BERT/GPT | 模型库 |

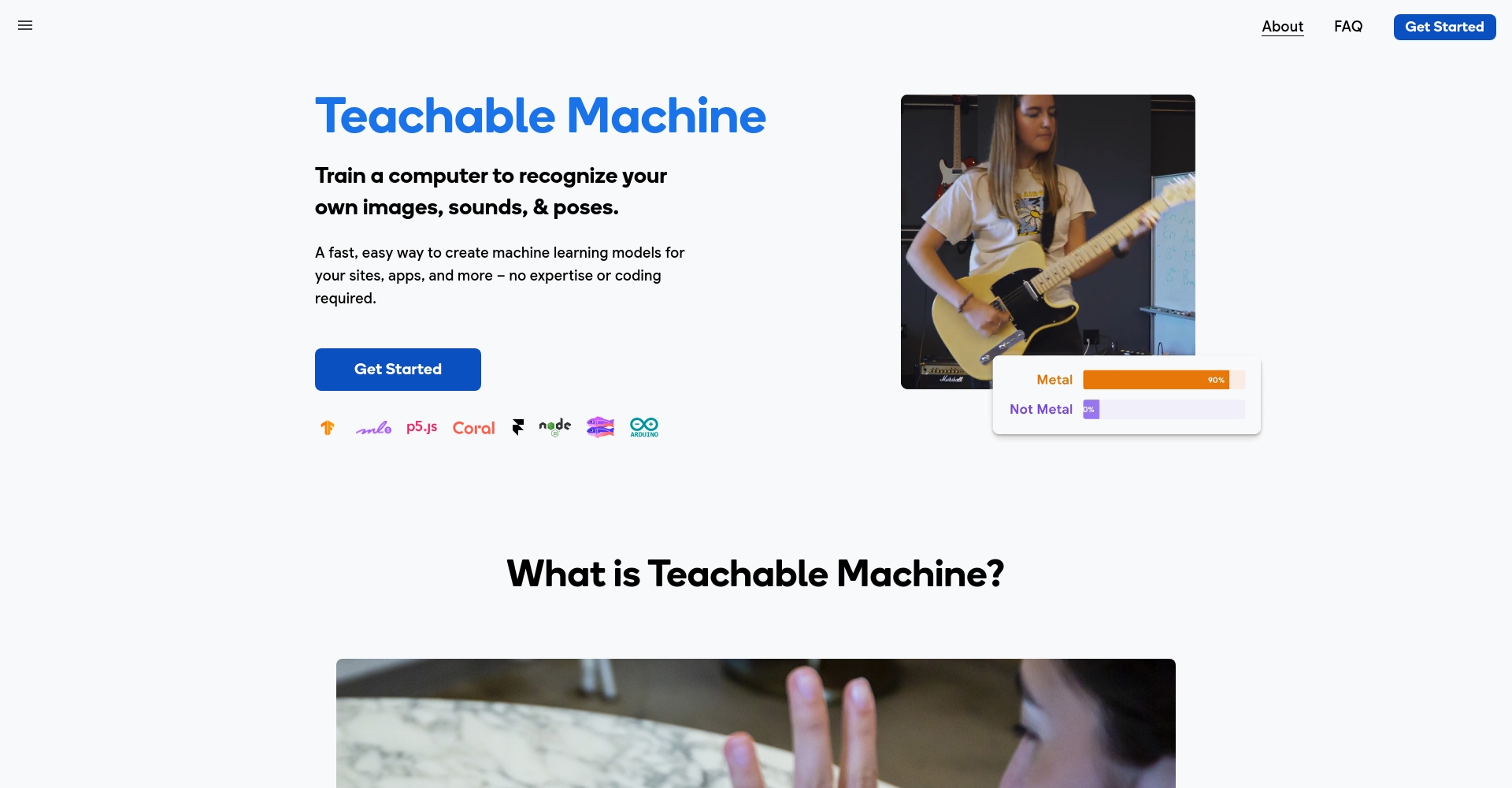

| Teachable Machine | 可视化迁移学习 | 全程零代码 | 点击体验 |

迁移学习操作流程(新手版全流程)

1. 选择合适的预训练模型

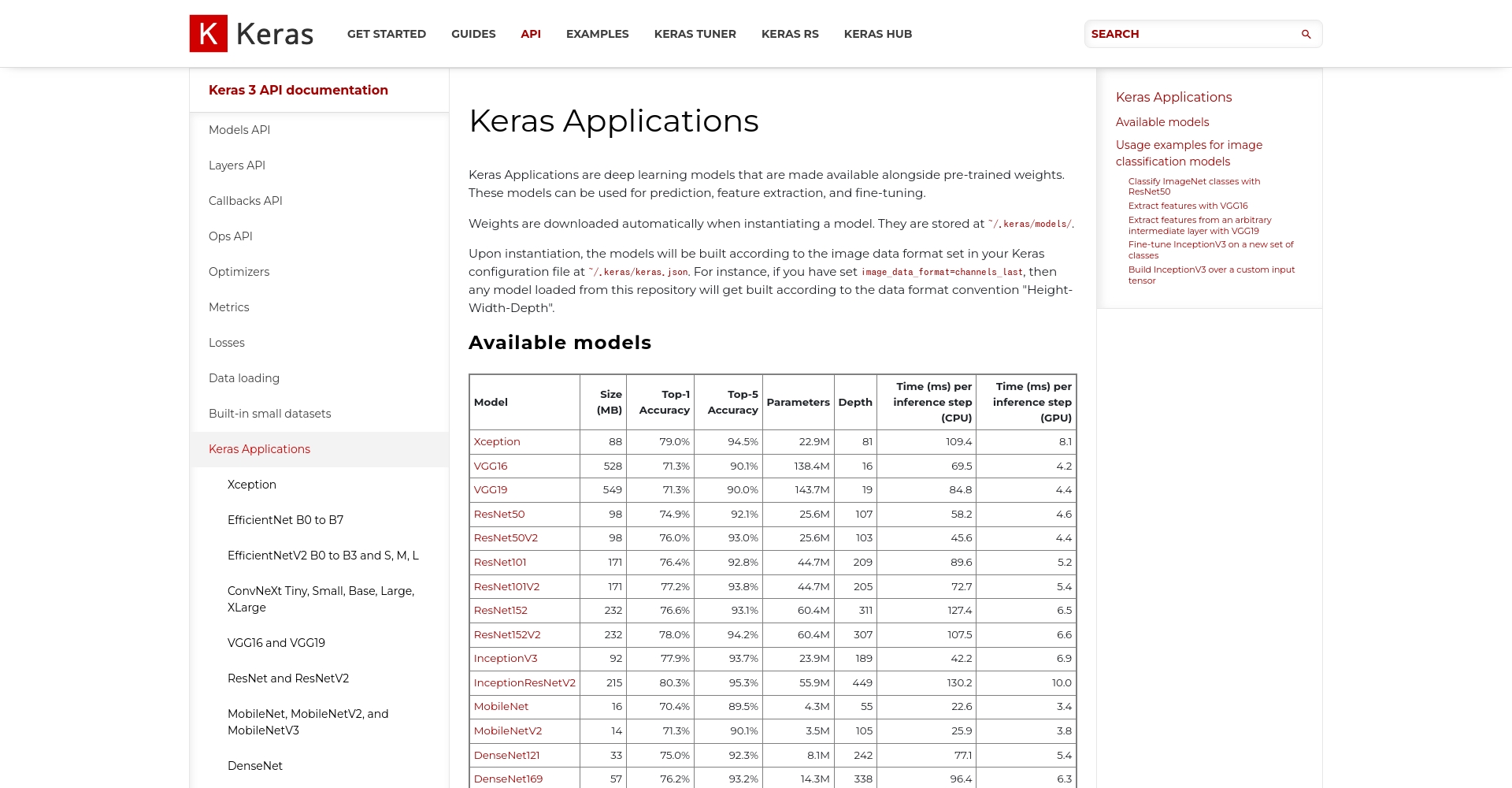

- 图像:ResNet、MobileNet、EfficientNet

- NLP:BERT、GPT-2等

- 声音:VGGish

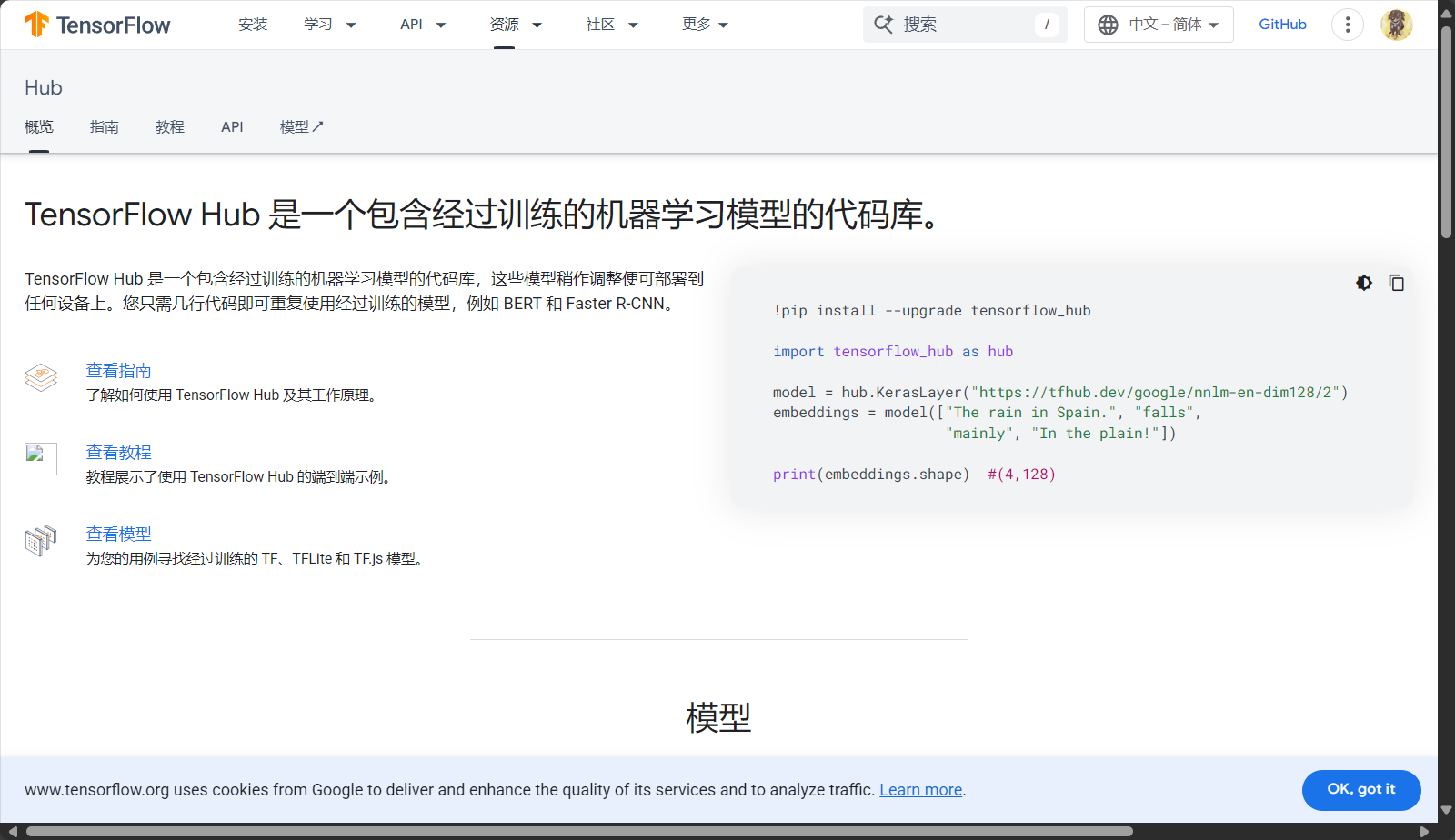

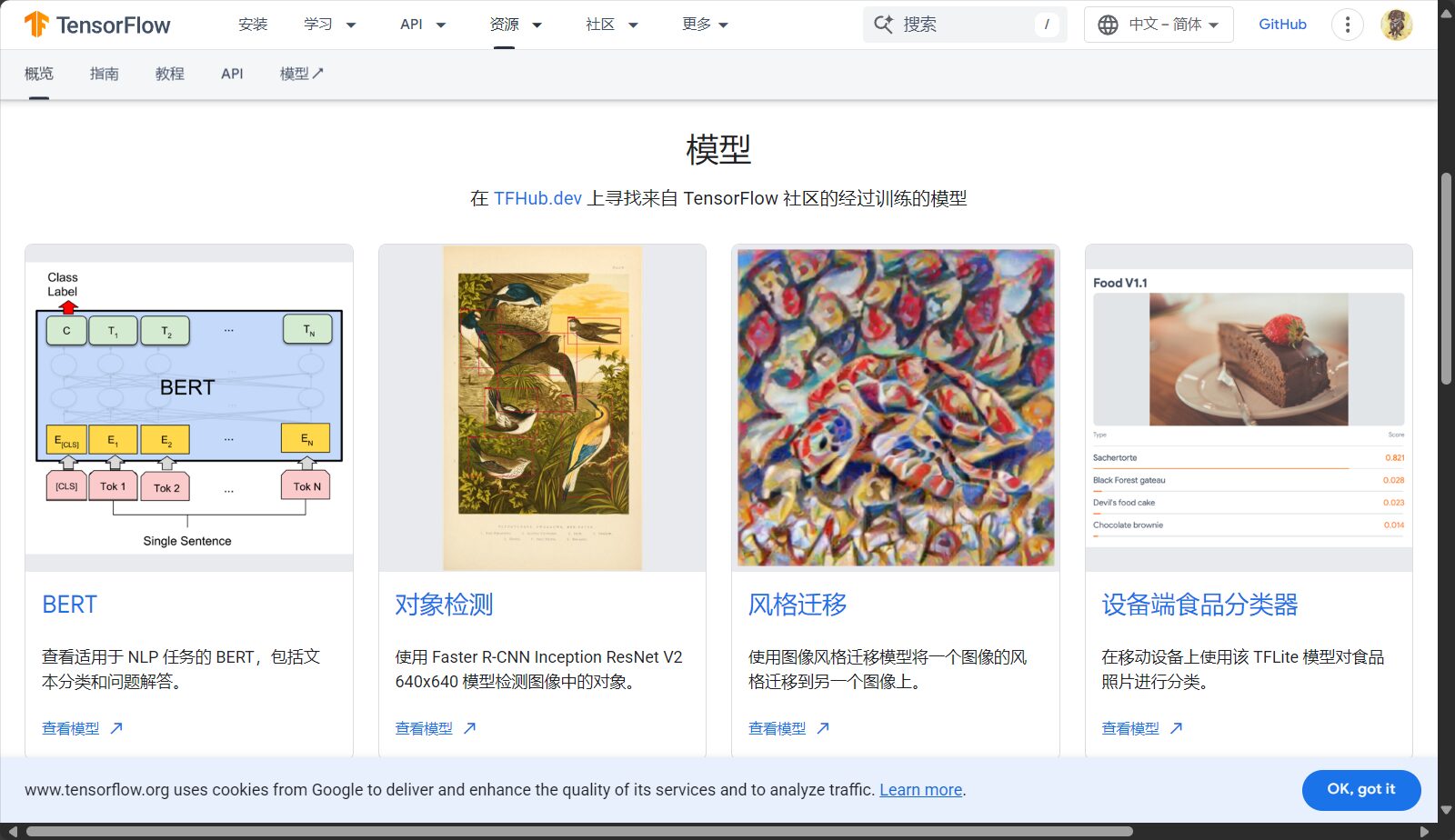

- 公开库:TensorFlow Hub、Huggingface

2. 准备目标任务小数据集

- 类型与结构最好对标预训练数据

- 30~200个样本即可实验

3. 搭建迁移学习流程

- 加载模型,冻结/解冻部分层

- 新加Softmax等输出层

- 设置学习率、训练次数

- 训练与评估

from tensorflow.keras.applications import MobileNetV2

from tensorflow.keras.layers import Dense, GlobalAveragePooling2D

from tensorflow.keras.models import Model

base_model = MobileNetV2(weights='imagenet', include_top=False)

x = base_model.output

x = GlobalAveragePooling2D()(x)

predictions = Dense(num_classes, activation='softmax')(x)

model = Model(inputs=base_model.input, outputs=predictions)

for layer in base_model.layers:

layer.trainable = False

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

4. 微调并持续优化

- 逐步解冻更多层,观测泛化与精度

- 尝试不同预训练模型

- 善用学习率回调、自动调参

优质迁移学习相关AI工具推荐

| 工具名称 | 支持场景 | 特色 | 难度 | 链接 |

|---|---|---|---|---|

| Teachable Machine | 图像/音频/姿态 | 网页化、零代码 | 极低 | 官网 |

| TensorFlow Hub | 图像/NLP/音频 | 预训练模型丰富 | 中等 | 入口 |

| Amazon SageMaker Jumpstart | 图像/NLP/多模态 | 云端部署、操作简 | 低 | 介绍 |

| HuggingFace Transformers | NLP为主 | 开源大模型丰富 | 中高 | 模型 |

| Google Colab | 通用 | 免费云GPU | 低 | 入口 |

迁移学习实践技巧&常见误区解读

新手如何避免踩雷?迁移学习易错点盘点

- 全冻/全解冻层误区:全冻模型适应力差,建议逐步解冻并做验证。

- 忽略输入数据归一化:预训练模型大都有专属归一化方式,对错误输入导致效果异常。

- 标签类别与输出层数不符:须完全对应。

- 模型太大部署卡顿:终端场景优先选轻量预训练模型。

迁移学习新手常见疑问Q&A

| 热门问题 | 答案要点 |

|---|---|

| 少样本能用迁移学习吗? | 适合!30-100样本也有优势 |

| 文本、音频能迁移吗? | BERT/wav2vec等均支持 |

| 哪些任务不适合迁移学习? | 完全无关的异构新任务不适合 |

| 传统ML能做迁移吗? | 部分支持如SVM线性特征迁移 |

迁移学习未来趋势与高阶应用展望

多模态与大模型时代的新机遇

随着大语言模型(LLM)和多模态模型的普及,迁移学习成为AI标配,支持少样本微调,助力拓展更多场景。

行业专用的迁移实践

医学、农业、金融等领域,利用迁移+大模型思路,用极小样本构建高可用模型。云平台纷纷提供一站式迁移能力。

无论你是AI新手或资深工程师,迁移学习(transfer learning)都在重塑AI开发范式。现在就动手,选一款迁移学习工具,开启你的自定义AI之路!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...