Gemma是Google最新发布的开源轻量级AI模型家族,主打开放权重、多模态能力和高度定制性,支持文本、图片等复杂场景,适合开发者、研究者及企业多平台部署。

免费获取模型,灵活本地或云端使用,低门槛推动AI创新。

2025年7月,Google宣布其最新开放AI模型平台Gemma正式登陆开发者与企业市场。 Gemma(官方网址点此)是Google DeepMind联合多部门倾力打造的轻量、开放、智能的AI训练模型工具家族,致力于推动研究创新与业务落地。

在生成式AI浪潮席卷全球之际,Google以Gemma为核心,为广大开发者、研究者、企业打开低门槛、高扩展性的新一代AI应用之门,在开放AI生态、技术安全与多模态能力上处于领先。

Gemma的主要功能

Gemma主打开放权重、高度定制与多模态能力,为AI训练模型赋能多元场景。 Gemma家族模型以生成式语言能力为核心,支持文本和图像输入,能够涵盖对话、摘要、理解、编码乃至视觉等多重任务,满足开发、研究与企业应用需求。

主要功能亮点

- 多模态输入:自Gemma 3起,支持文本和图片同时处理,具备视觉语言能力,如图片内容分析、文本问答、对象识别等。

- 超长上下文窗口:支持128K token,轻松处理超长文档或批量图片,适用于法律、医疗等大文本场景。

- 强大多语言支持:原生支持140+种语言,全球化AI开发无障碍。

- 灵活模型参数及量化:涵盖1B、4B、12B、27B参数规模,支持32~4位多级别量化。

- 开放权重及自定义训练:所有模型权重开放,支持二次微调与定制,适配专属数据。

- 函数调用及结构化输出:便于智能对话、自动化代码等API深度集成。

- 安全与审计:如ShieldGemma图片安全分类器,帮助企业合规排查高风险内容。

| 型号 | 参数量 | 输入 | 输出 | 推荐硬件 | 32位显存 | 8位显存 | 4位显存 |

|---|---|---|---|---|---|---|---|

| Gemma 1B | 10亿 | 文本 | 文本 | 手机/笔电 | 4GB | 1.1GB | 892MB |

| Gemma 4B | 40亿 | 文本/图片 | 文本 | 台机/轻服务器 | 16GB | 4.4GB | 3.4GB |

| Gemma 12B | 120亿 | 文本/图片 | 文本 | 高端桌面/服务器 | 48GB | 12.2GB | 8.7GB |

| Gemma 27B | 270亿 | 文本/图片 | 文本 | 服务器集群 | 108GB | 29.1GB | 21GB |

更多技术细节:Gemma 3技术报告

多样化模型家族

- Gemma Core:(1B/4B/12B/27B)文本和视觉生成、推理、摘要等多任务。

- CodeGemma:代码生成、自动补全。

- PaliGemma:图片问答、视觉摘要。

- ShieldGemma:内容安全审计及检测。

- TxGemma:医学和垂类预测、推理。

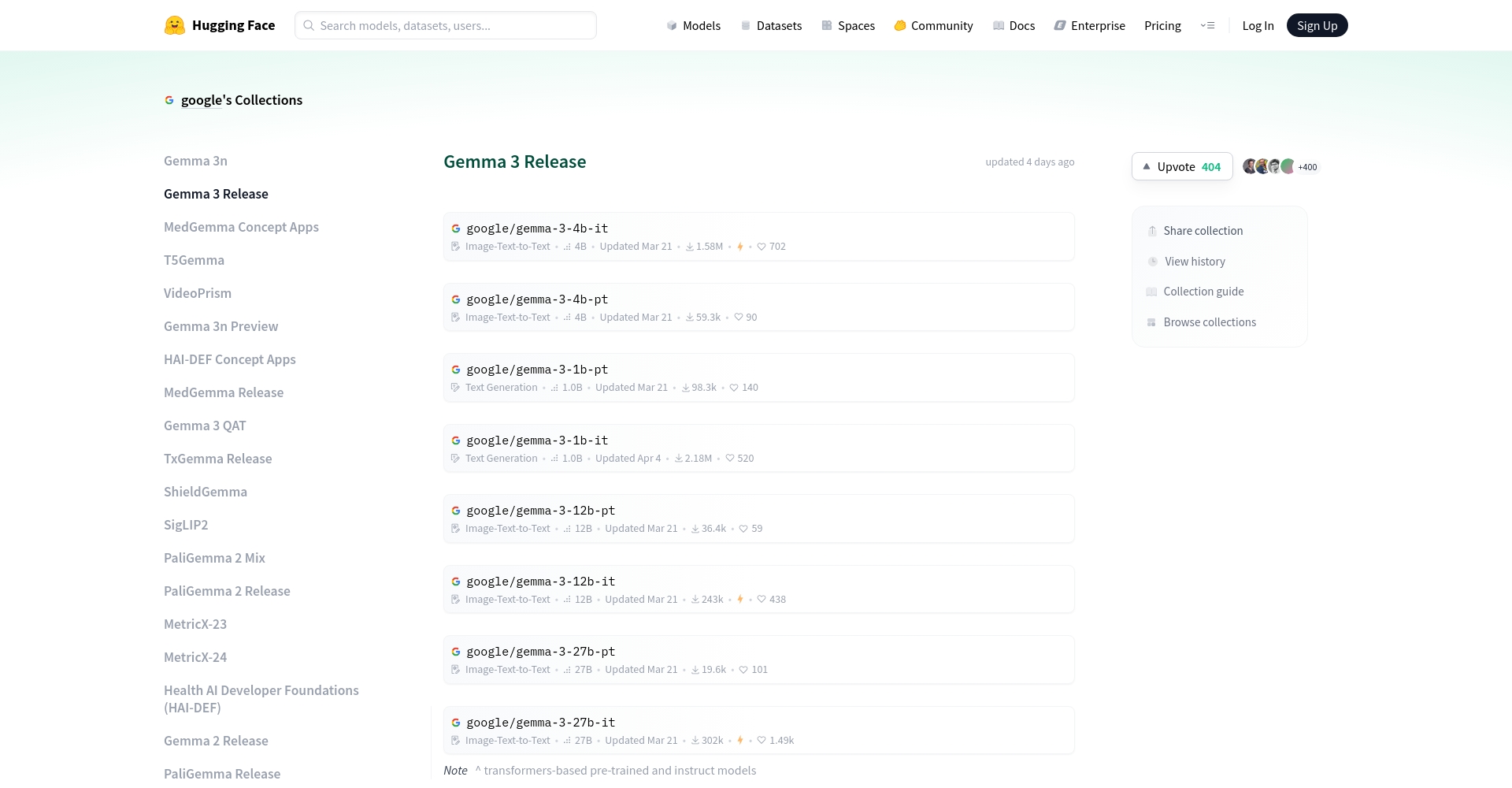

Gemma模型可通过Hugging Face与Kaggle免费下载使用。

Gemma的价格 & 方案

Gemma秉承开放策略,模型权重完全免费,支持多平台自由部署与训练。如需更高性能的云端API、企业级服务,可选用Google Cloud相关付费方案。

定价方案速览

| 方案 | 价格 | 说明与适用场景 |

|---|---|---|

| 本地模型下载 | 免费 | Hugging Face/Kaggle下载权重,本地或自有服务器部署 |

| Google Colab | 免费/升级版 | 免费试用Gemma,微调与推理,付费可获更高资源 |

| Google Cloud AI | 新用户$300赏金 | 云端API推理/训练,首开账户送$300,适合企业与科研 |

| Vertex AI | 按用量计费 | 主打企业级AI部署,API调用即付 |

可参考费用详情和试用

如何使用Gemma

Gemma支持多框架多平台,适合零基础到专业级用户,操作便捷。官方入门指引

核心使用方式

- 下载模型权重:

访问Hugging Face或Kaggle选择需要的模型。 - 开发框架选择:

Keras、PyTorch、JAX、Transformers等均兼容支持(详细教程),也可Gemma.cpp、Ollama边端运行。 - 推理与微调:

支持本地/云端prompt推理、LoRA/QLoRA高效微调,小样本适用。微调教程 - 一站式部署:

企业支持Vertex AI、GKE、Dataflow等MLOps集成云服务。

集成步骤简要

| 步骤 | 简述 | 参考链接 |

|---|---|---|

| 获取权重 | 下载权重文件 | Hugging Face |

| 环境配置 | 安装库加载模型 | 官方文档 |

| 推理调用 | 编写脚本 | 快速指引 |

| 部署上线 | 集成员工/云端/手机 | 部署教程 |

新手推荐从Colab在线试用,官方Notebook示例

Gemma的适用人群

Gemma以开放易用、安全多元、兼容性强的优势,成为以下群体AI开发首选:Gemma社区案例

主要适用对象

- AI开发者/创业者团队:自定产品如对话机器人、生成式内容等。

- 学术研究者:开放权重、可微调、便于创新方法论研究。

- 中小/大型企业IT:低成本私有部署,数据合规安全。

- AI教育/培训:新技术教学、实验。

- 全球化/本地化需求开发者:多语种交互,适配不同地区。

典型适配场景举例

| 场景 | 模型/能力 | 说明 |

|---|---|---|

| 智能客服 | Gemma 3 4B/12B | 多轮问答、自动摘要 |

| 文本生成摘要 | Gemma 3 1B/4B | 长文档处理 |

| 图片内容审核 | ShieldGemma 2 | 合规、安全分类 |

| 编程自动化 | CodeGemma | 代码补全分析 |

| 多语言教学 | Gemma 3 | 140+语言支持 |

| 医学垂直领域 | TxGemma | 领域定制、推理预测 |

Gemma平台生态与安全合规

Gemma高度重视责任AI与内容安全。 Google在Gemma平台设计了多样责任组件(Responsible GenAI Toolkit、限制策略等),结合ShieldGemma支持自动内容审核、敏感信息拦截与合规追踪。

- 防偏见与滥用:全流程去偏与层级内容管理。

- 研发合规性:符合Google Responsible AI政策,保障健康发展。

更多说明见社区政策页

Gemma的技术生态与社区创新

Google鼓励开发者/研究者进行创新模型研发与生态共建。Princeton NLP等科研机构,以及OmniAudio多模态扩展案例,已丰富Gemmaverse社区 。

Gemma与Hugging Face、Ollama、Vertex AI、Colab、Keras等平台无缝衔接,可高效集成行业业务链路。大大加速AI技术民主化进程。

常见问题

Gemma和Gemini区别?

Gemini定位旗舰,超大规模多模态AI,Gemma主打开源轻量、低门槛、可本地化部署,适合私有化和创新开发。 详见Gemma vs Gemini官方说明

如何本地部署Gemma?

直接下载权重,按硬件选择参数/精度,配合PyTorch/Keras等或Ollama、Gemma.cpp等工具实现本地推理与训练。无需依赖云,详见部署指南

支持定制化领域微调吗?

Gemma支持定制化微调(如LoRA/QLoRA),支持本地/云端多场景。 详见微调教程。请注意微调显存需求比推理高。

Gemma的发布,意味着生成式AI民主化迈出新步伐。个人和企业均可在Gemma生态中创新和成长,推动下一代AI广泛应用。体验更多,请访问Gemma官网。

数据统计

数据评估

本站AI 喵导航提供的Gemma都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI 喵导航实际控制,在2025年7月14日 下午5:30收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI 喵导航不承担任何责任。

相关导航

美间AI无损放大

AISEO

百度作家平台

文思助手

Llama 3

Pixian.AI

超能画布