全面解析Lamini:企业级AI训练模型平台的先锋

在AI革命浪潮下,更多企业希望低门槛搭建定制化大语言模型(LLM)。Lamini,正是在这一趋势下脱颖而出的企业级平台,提供从AI训练模型、模型调优到推理服务的一站式解决方案。本文将以新闻报道的风格,为广大企业与开发者深度解析Lamini的核心价值、技术亮点与应用潜力。

全面解析Lamini:企业级AI训练模型平台的先锋 在AI革命浪潮下,更多企业希望低门槛搭建定制化大语言模型(LLM)。Lamini,正是在这一趋势下脱颖而出的企业级平台,提供从AI训练模型、模型调优到推理服务的一站式解决方案。本文将以新闻报道的风格,为广大企业与开发者深度解析Lamini的核心价值、技术亮点与应用潜力。

(官方网址: https://lamini.ai/)

Lamini平台简介 Lamini是一家位于美国加州、于2022年成立的AI科技公司,其核心产品Lamini平台为企业提供开放LLM(大型语言模型)的训练、优化和部署服务,强调“企业级AI训练模型的极致简化”。无论本地、私有云还是公有云,Lamini都能兼容部署,并全面支持NVIDIA与AMD GPU硬件,加速企业越级迈入AI新时代。 查看官网更多信息 Lamini的创始团队具备强大的学术与产业背景——科研成果覆盖LLM扩展定律、生产环境AI大规模迭代,以及亚马逊、Google、OpenAI等业界标杆经验。平台面向所有具备AI需求的企业,不再限定机器学习博士或专职AI团队,降低了行业进入壁垒。

Lamini的主要功能 Lamini以“低代码”、“高兼容性”、“高可控性”为主要理念,致力于帮助企业灵活拥有自己的AI训练模型,主要功能亮点如下:

(详细开发文档与官方Demo,请访问Lamini Docs)

1. 快速AI训练模型定制

支持LoRA等微调技术,通过自有API和Python SDK,无需ML专家、仅几行代码即可完成本地/云端高质量微调。 配备RLHF(人类反馈强化学习)、Prompt Engineering等优化路径,助力模型生成准确性大幅提升。

2. 数据生成与扩充

内置强大的生成器,可将小批量数据自动扩展为海量训练集,支持实用场景如问答、摘要、结构化信息生成。 数据验证与自动清洗工具,极大减轻企业数据前置处理压力。

3. 高速推理与批量推理

极致高吞吐推理API,适合大规模文本、文档的后台批量推理与实时响应场景。 结构化JSON输出,便于和企业系统做深度集成,极大降低应用出错率。

4. 多环境灵活部署

跨本地(on-prem)、公有云(如AWS、GCP)、私有云和隔离网络(air gapped)灵活部署。 支持GPU集群自动编排,轻松应对百万级并发训练与推理请求。

5. 数据与安全合规

企业级数据隔离与安全,确保自有数据绝不外泄,为合规性强需求客户提供有力基础。 管理工具可自定义日志、权限、调用频次及模型版本回溯。

主要功能速览表

| 功能类别 | 说明 | 技术特色 |

|---|---|---|

| 模型训练与优化 | LLM定制与个性数据微调 | 支持LoRA、RLHF等 |

| 数据生成与扩充 | 小样本生成大数据 | Prompt工程/自动清洗 |

| 推理与集成 | 快速API批量推理+结构化输出 | 高吞吐量/JSON结果 |

| 部署与兼容 | 本地、云端、GPU自动扩展 | 支持NVIDIA、AMD/多云环境 |

| 安全与管理 | 权限全控、数据隔离、审计溯源 | 企业级加密/合规支持 |

详细API和业务场景示例可进一步查阅Lamini官方文档。

Lamini的价格 & 方案 Lamini面向不同类型企业,按需提供灵活的价格与服务方案。其主要定价模式总结如下:

| 方案类型 | 主要对象 | 获得的服务 | 价格 |

|---|---|---|---|

| 免费套餐 | 开发者/小规模实验 | 200次推理/月+有限调优尝试 | $0 |

| 企业套餐 | 中大型团队/企业 | 无限推理/调优/私有模型权重下载/专家支持 | 定制(需联络销售) |

免费注册即送$20试用推理积分,适合初学者体验 企业版不限模型类型与容量,可完全定制吞吐量与时延需求,还能直接下载微调后模型权重 支持信用卡支付及企业账期,详细结算方式与定价以官网最新公告为准

特别说明:针对高频批量AI训练模型与大规模推理客户,Lamini可提供GPU预留、专属带宽、自定义安全加固等深度企业级合作选项。 点击联系Lamini团队获取定制报价

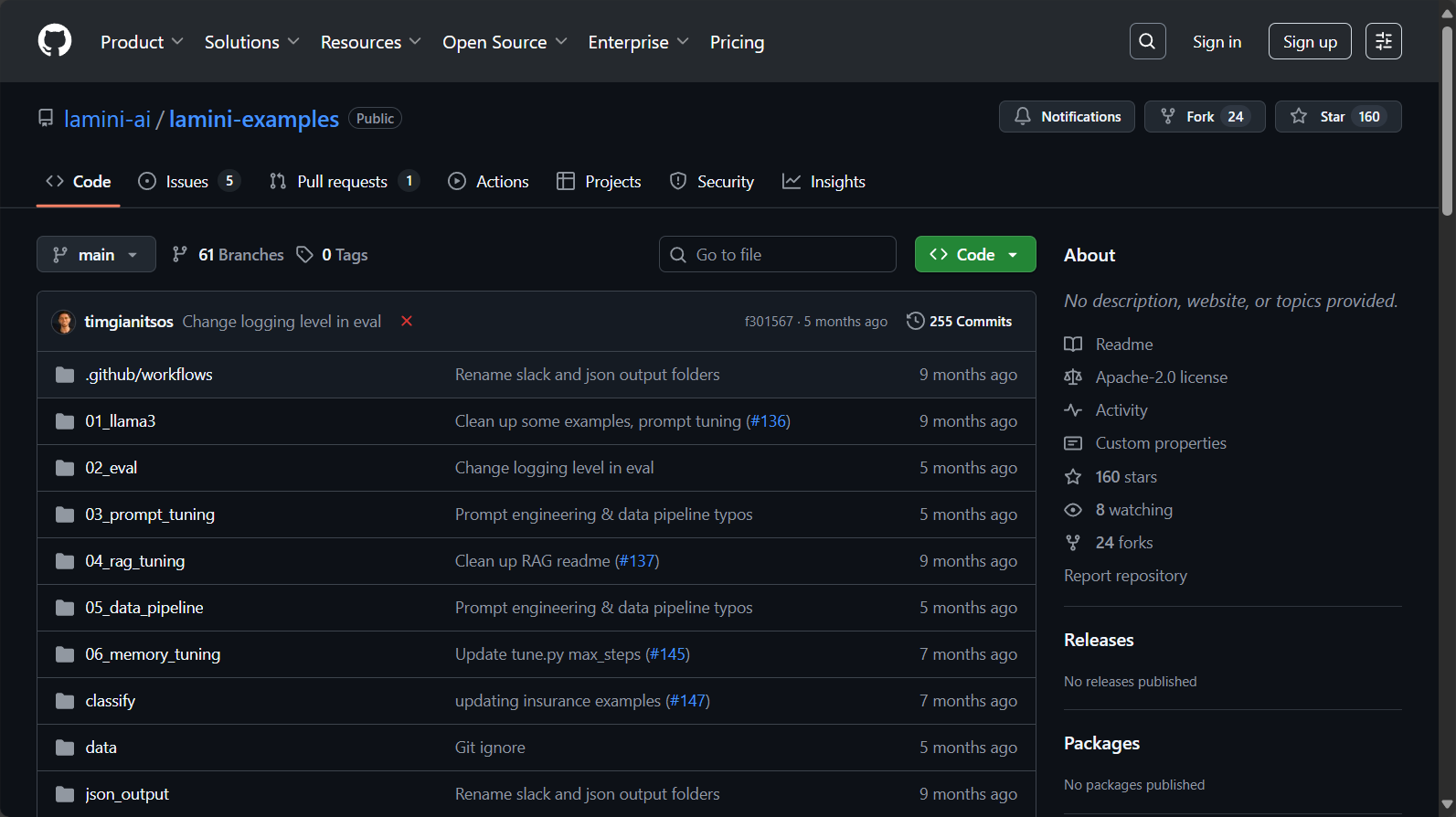

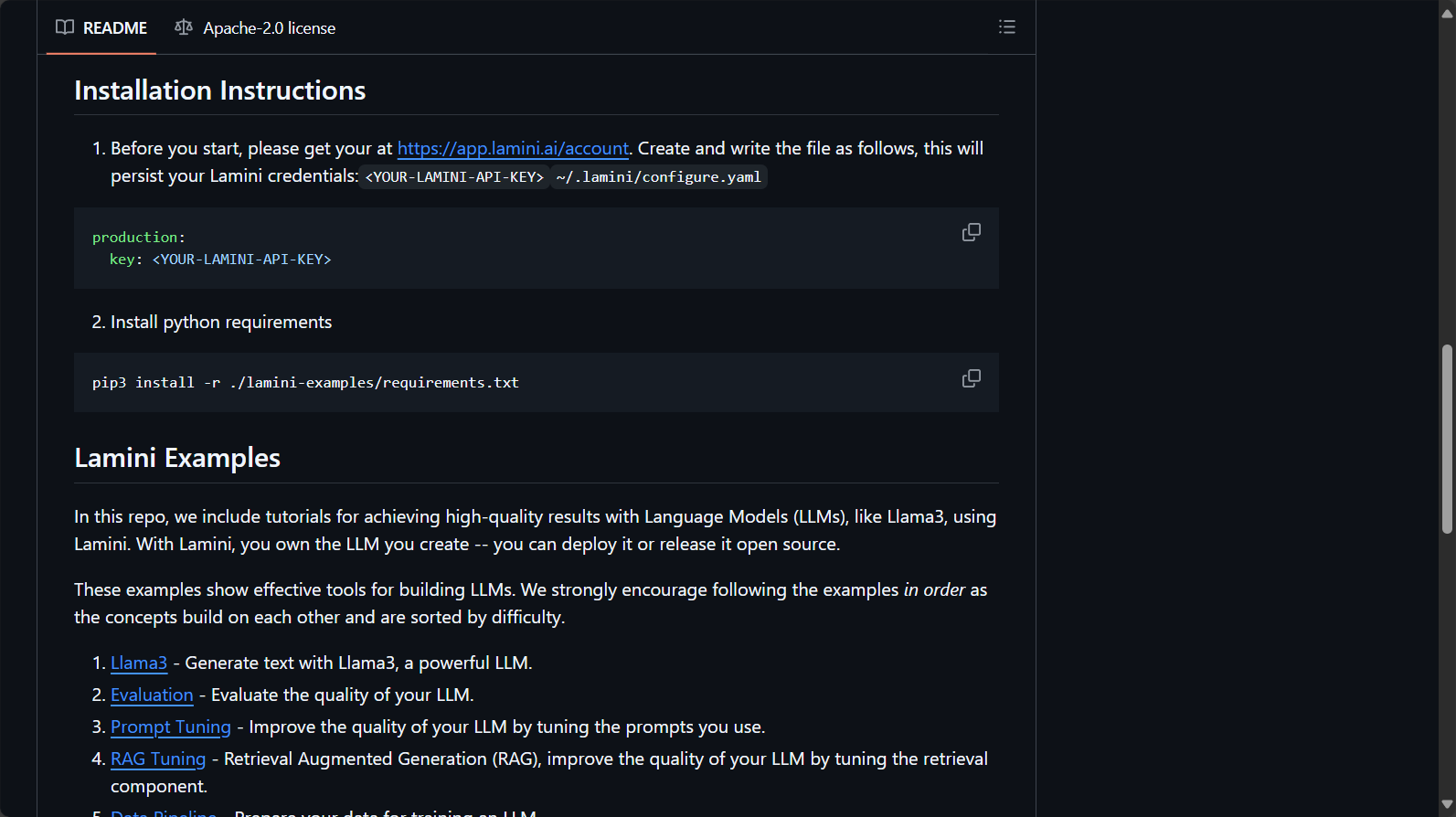

如何使用Lamini 1. 账户注册与API申请 前往hugging faceLamini在线体验。 支持Python SDK、RESTful API对接,无论是小工具工程师还是企业IT都可快速集成。

2. 基础模型定制流程

上传/配置企业私有数据(如知识库、合同、FAQ等)。 通过平台自动数据生成器扩展训练样本。 选择/上传基础LLM(平台可兼容多种主流开源/自研模型)。 调用API或用Python SDK

from lamini import train_llm model = train_llm(task=’qa’, data=your_data, …)

微调完成后,模型可立即上线推理,或导出权重本地部署。

3. 集成与二次开发

Lamini可作为内部AI中台,结合内业务数据,低代码扩展知识问答、文档生成、智能客服等场景。 支持高并发异步批量请求,有详细团队协作与版本管理机制。 使用过程中如遇问题,可通过开发文档社区提问、或联系官方技术支持。

Lamini的适用人群 主要适用对象

| 适用人群 | 理由与应用场景 |

|---|---|

| 企业/大中型机构 | 需处理海量专有文档、数据安全性高等定制化AI需求 |

| AI初创公司 | 需快速搭建PB级模型、敏捷上线新功能 |

| IT/数字化团队 | 用于内部知识库对话助手、智能运维、企业流程优化等 |

| AI教育科研机构 | 验证新模型理论、生成教学或科研范例 |

| AI外包服务商 | 实现多用户、多业务场景下的LLM快速交付 |

典型行业案例

金融:自动生成报告、反欺诈风控文本分析、智能投顾 医疗:病例解读、文档摘要、科普内容自动生成 零售/电商:商品文案生成、客服机器人、客户舆情分析 制造业:工艺文档写作、维护知识库对话、合规材料归集

Lamini为何成为领先AI训练模型平台? 技术创新与产业应用的深度融合,是Lamini最大特点:

定制化高精度:Memory Tuning、LoRA调优+Experts in-the-Loop多维提升企业数据上的任务准确率 推理资源极致利用:同等硬件下GPU利用率提升32倍,支持AMD GPU,打破NVIDIA一家独大 全景部署能力:可本地、断网、混合云灵活部署,数据始终可控,企业IT安全合规得以保障 开发者友好:以开发者至上的API和简单的SDK为根本,文档完善,降低AI落地门槛

与常见开源自训框架/云端API一站式能力对比:

| 维度 | Lamini | Huggingface | OpenAI平台 | 微调难度 | 兼容性 | 推理吞吐 | 企业专用性 | 数据全控性 |

|---|---|---|---|---|---|---|---|---|

| ☆☆☆☆☆ | 轻松 | 较高 | 仅限API | 低 | 高 | 极高 | 极强 | 极佳 |

深入了解Lamini技术文档

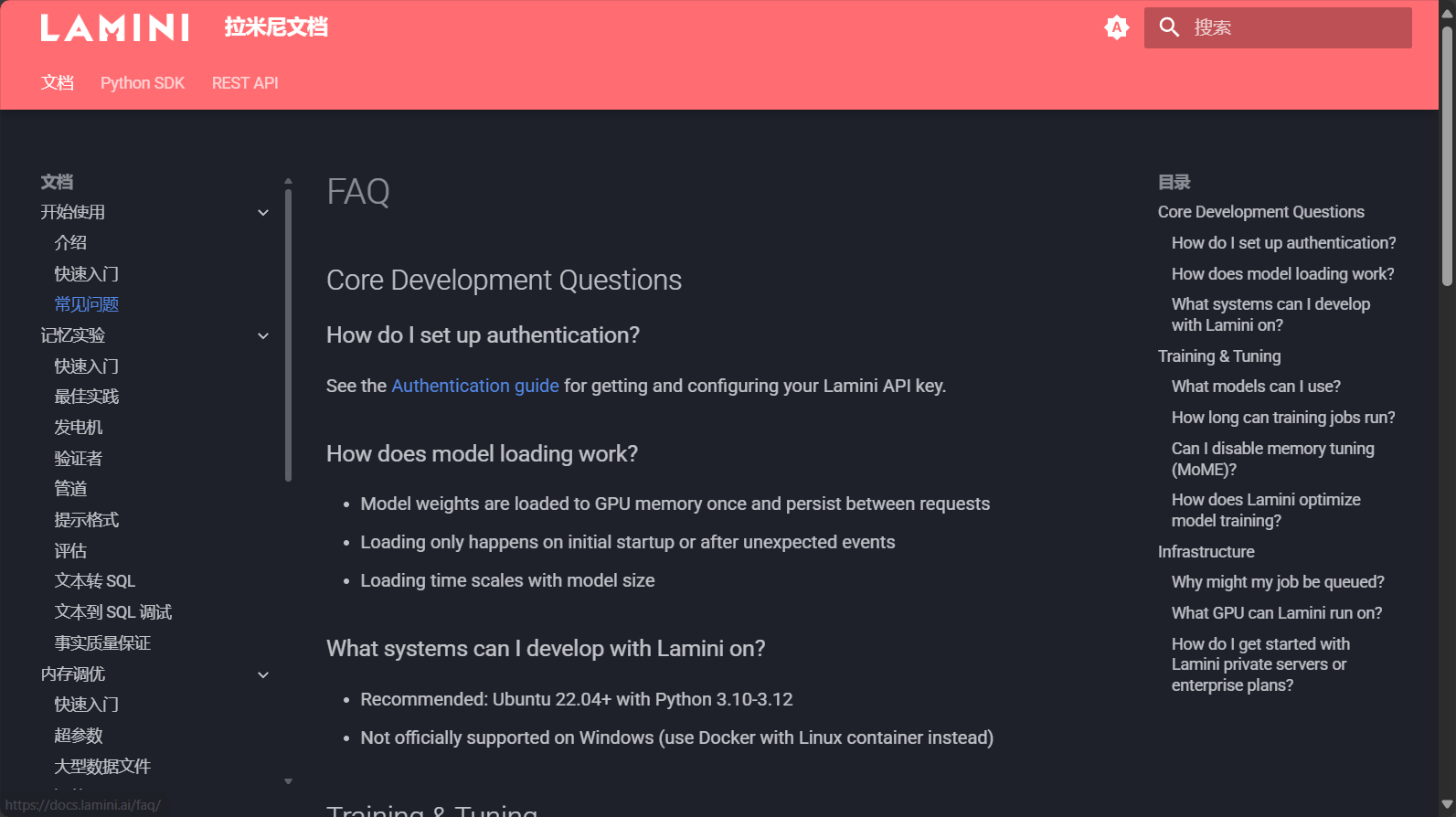

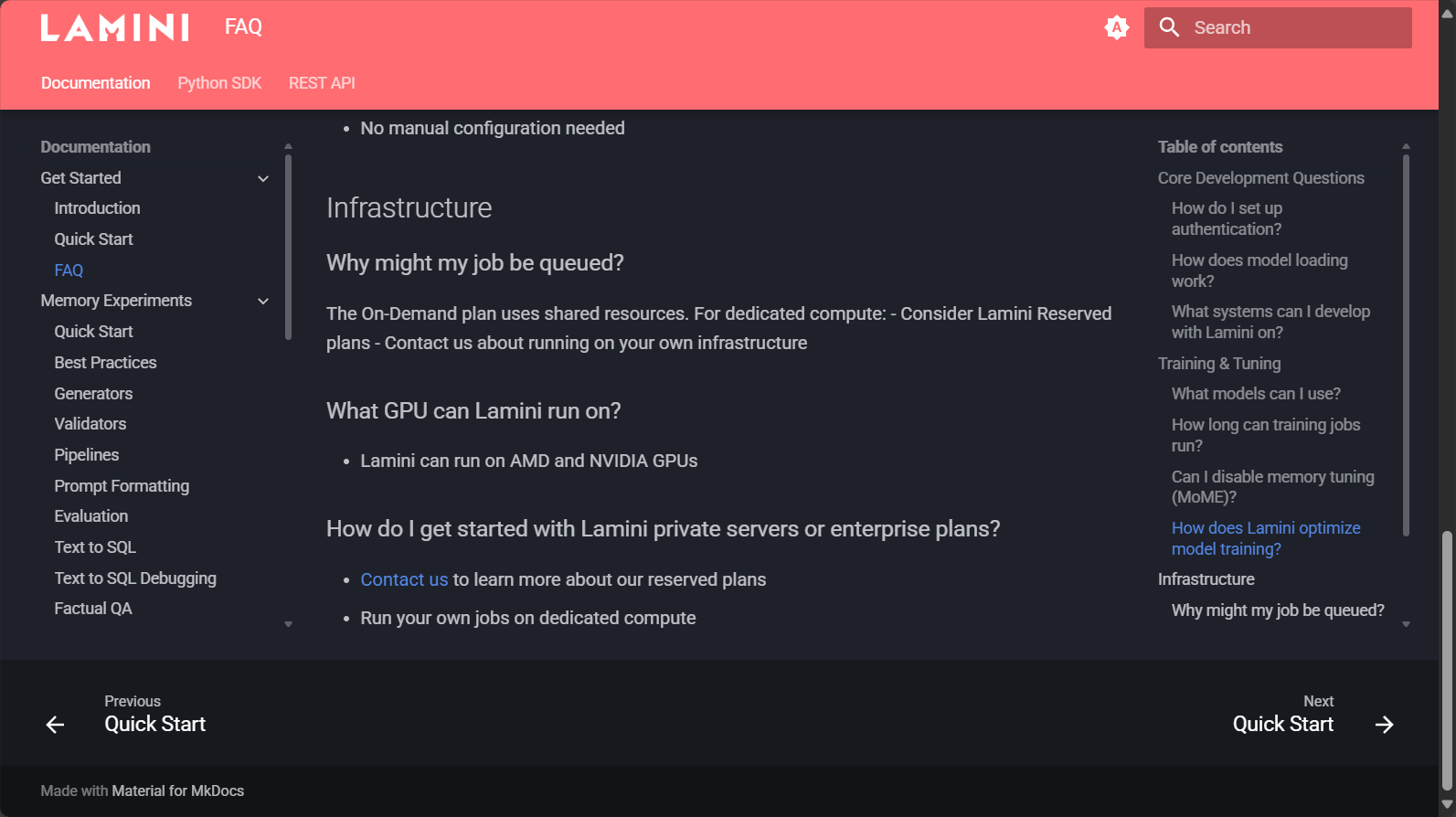

常见问题 1. Lamini支持哪些AI模型的训练与微调? Lamini完全模型无关(model-agnostic),支持主流开源LLM(如Llama、GPT-3/4家族、Mistral等)及企业自研基础模型的自助训练、调优与推理,兼容无缝切换,无需担心“只支持平台自研模型”局限。 更多详情见官网支持模型列表

2. Lamini部署与数据安全如何保证? 平台原生支持本地私有部署及隔离网络环境,所有企业数据、模型参数可100%留在自有基础设施中。平台还具备详细数据加密、访问权限控制与安全审计机制,适用于对数据隐私与合规性极度敏感的金融、医疗等行业。 访问“Self-Hosted”部署指南

3. Lamini与开源自训 or 纯API云模型有何核心差异?

Lamini倡导“低门槛专属模型”,让非AI专业团队快速拥有自己的AI训练模型,并能下载权重、自主管理与升级; 并非“即抛即用API”,更强调企业数字资产安全与AI可持续成长能力; 同时,Lamini整合了微调、数据生成、推理接口、权限管理、监控等全流程,极大降低IT集成工作量。完胜“光有训练不易落地”的科研工具,也规避全部依赖第三方云AI的风险。

结语 Lamini正在驱动AI训练模型技术大步走向企业级自主时代。它不仅为大企业解决了数据安全、性能与快速落地的痛点,也极大压缩了新锐团队与AI巨头的技术鸿沟。对于未来中国企业想占据AI智能业务的高地——拥抱Lamini这样可掌控、自成长的AI训练模型平台,无疑是最具前瞻性的战略选择之一。

想要体验Lamini的智能力量?现在就访问其官方网站,开启定制企业AI模型的新纪元!

数据统计

数据评估

本站AI 喵导航提供的Lamini都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI 喵导航实际控制,在2025年7月26日 下午12:02收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI 喵导航不承担任何责任。

相关导航

问小白

GoProd

Visual Electric

REMOVAL.AI

鲜艺AI抠图

RunningHub

Sudowrite