2024年6月,人工智能大语言模型步入规模化时代。DeepSpeed,由微软研发并开源,以其卓越的优化技术成为全球AI开发者的重要工具。DeepSpeed具备高效的多GPU、多机分布式训练能力,使得大规模AI模型训练更为高效、成本更低。其核心技术包括DeepSpeed-Training、DeepSpeed-Inference、DeepSpeed-Compression以及DeepSpeed4Science四大支柱。用户可以在本地或Azure云端部署,体验免费且高性能的AI模型训练。

2024年6月,人工智能大语言模型狂飙突进,从GPT-4、BLOOM到最新的企业级应用,大规模AI训练模型已经成为业界力争高地。随着模型参数量步入数十亿,甚至上千亿级别,训练和推理的成本与难度也呈指数增长。由微软研发并开源的DeepSpeed,正以其极致的优化技术,彻底改变这一局面,成为全球AI开发者不可或缺的“基础设施”。

访问DeepSpeed官方站点:https://www.deepspeed.ai/

什么是DeepSpeed?

DeepSpeed 是一款深度学习优化软件套件(Deep Learning Optimization Software Suite),专为训练和推理超大规模模型打造,被普遍应用于如MT-NLG、BLOOM、Jurassic-1等顶级大模型的训练场景。DeepSpeed追求极致高效,主打在多GPU、多机分布式环境中,将训练速度最大化、资源利用最优、成本大幅降低。

它不仅适用于大模型,也能让中小型团队在更平价硬件上完成以往需“巨无霸”服务器集群的任务。

DeepSpeed的主要功能

技术创新四大支柱

DeepSpeed的核心创新分为四大支柱,每一项都面向AI训练和推理中的痛点:

| 支柱 | 主要功能 |

|---|---|

| DeepSpeed-Training | 设计用于突破性的大规模并行训练(如ZeRO、3D-Parallelism、Mixture-of-Experts、ZeRO-Infinity等),显著提升训练效率与规模。 |

| DeepSpeed-Inference | 通过张量、流水线、专家模型、ZeRO等多种并行技术和内核优化,实现超大模型的高效低延迟推理。 |

| DeepSpeed-Compression | 提供易用、高灵活度的模型压缩方案(如ZeroQuant、XTC等),在不影响表现下大幅减小模型体积、加快推理速度、节省成本。 |

| DeepSpeed4Science | 结合系统优化与科学算力,助力生命科学、物理等前沿领域,大幅提升科研AI模型的训练效率。 |

详细技术介绍可查阅 DeepSpeed技术支柱页面。

DeepSpeed-Training

- 突破性分布式训练优化,如ZeRO系列优化器,使多节点数千GPU上线性扩展,轻松支撑千亿参数模型训练。

- 3D-Parallelism,实现张量、流水线、数据三维并行,极致挖掘计算与内存带宽。

- MoE(专家模型)训练优化,自动管理稀疏激活大模型,训练稀疏参数更高效。

DeepSpeed-Inference

- 超大模型低延迟推理,结合自研高性能推理内核和通信优化,千亿级模型也能快速、多并发服务上线。

- 异构内存调度,支持CPU+GPU/NVMe混合存储,极大降低显存要求。

DeepSpeed-Compression

- 压缩与量化一体化,内置ZeroQuant、XTC等前沿技术,支持全自动压缩,方便预测部署。

- 灵活并可组合的压缩API,兼容科研与工业需求。

更多详见 DeepSpeed功能列表。

DeepSpeed的价格 & 方案

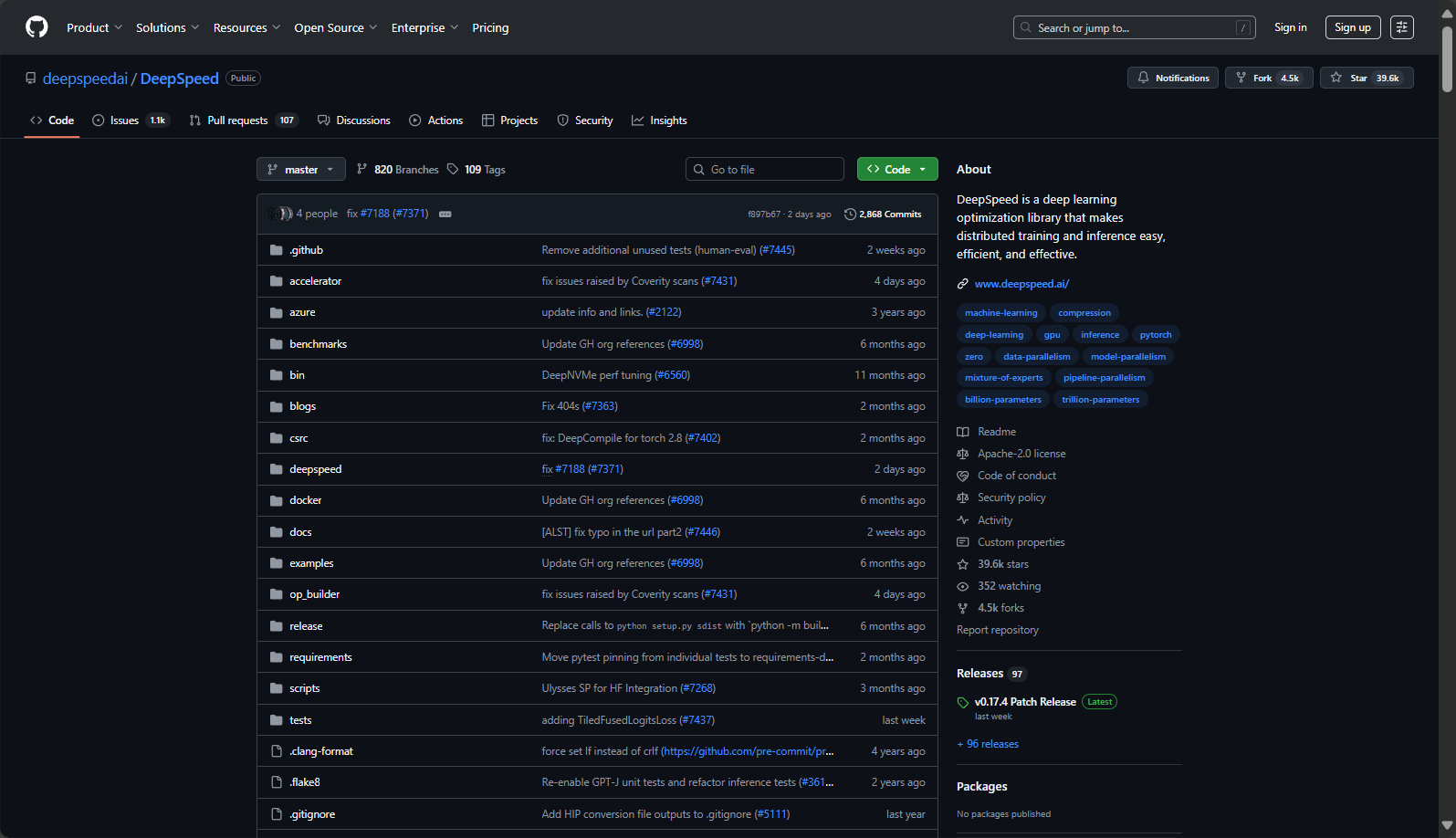

DeepSpeed完全开源免费,用户可以在GitHub快速获取源代码,企业商用、科研均可无门槛使用。官方还提供:

- 深度Hugging Face Transformers、PyTorch、PyTorch Lightning集成,降低模型迁移与二次开发门槛。

- 微软 Azure 上完整支持,可直接通过AzureML一键开启分布式训练。详见 AzureML官方指引。

| 方案 | 价格 | 适用场景 |

|---|---|---|

| 开源本地部署 | 免费 | 内部或科研数据、可自定义环境 |

| Azure云端AI训练 | 按云资源计费 | 弹性扩展、高性能集群、大规模生产环境 |

| 社区支持与企业合作 | 部分商业服务费 | 定制化技术支持、行业级持续集成 |

DeepSpeed不收取独立授权或使用费,社区与企业服务请参见DeepSpeed社区。

如何使用DeepSpeed

安装

DeepSpeed支持Linux、Windows、主流GPU架构(包括NVIDIA、AMD、Intel支持),简单pip一行即可:

pip install deepspeed详细环境&加速器支持见 设备兼容性列表。

快速集成训练/推理代码

以PyTorch为例,只需三步:

1. 配置DeepSpeed参数(ds_config.json)

{

"train_batch_size": 8,

"gradient_accumulation_steps": 1,

"optimizer": {"type": "Adam", "params": {"lr": 0.00015}},

"fp16": {"enabled": true},

"zero_optimization": true

}

2. 初始化DeepSpeed引擎(训练示例)

import deepspeed

model, optimizer, _, _ = deepspeed.initialize(args=cmd_args, model=model, model_parameters=params)3. 启动分布式训练命令

deepspeed --num_gpus=4 <train_script.py> --deepspeed --deepspeed_config ds_config.json详细用法可见官方入门教程。

云端一键试用

微软Azure通过AzureML提供DeepSpeed模板,适合云计算弹性资源的大规模AI训练场景。

Hugging Face、Lightning原生集成

一句命令+config即可让Transformers、PyTorch Lightning任务接入DeepSpeed加速,见 HF集成教程。

DeepSpeed的适用人群

| 角色 | 使用价值 |

|---|---|

| AI研发团队 | 训练千亿参数大模型,极大降低成本与开发难度 |

| AI创业公司 | 利用开源集群,低门槛实现行业领先的模型训练 |

| 学术科研团队 | 扩展论文级实验规模,推动大模型理论与新算法突破 |

| 云服务&大厂 | 面向SaaS/PaaS AI服务,支撑超高并发与大模型推理低延迟部署 |

| DL框架开发者 | 深度集成分布式优化与模型压缩技术,开放自定义优化与插件框架 |

适合一切对AI训练模型有高性能、低成本、易扩展需求的企业与个人。

DeepSpeed集成与生态

DeepSpeed拥有高度开放与丰富的生态:

- 与主流DL框架无缝集成:如Hugging Face Transformers、Accelerate、PyTorch Lightning、MosaicML等一键对接,

- 案例见集成文档。

- 支持云原生与本地部署:Azure、Kubernetes等平台均有官方部署示例。

- 主流AI大模型标配:MT-530B、BLOOM、Jurassic-1、GLM、GPT-NeoX等均使用DeepSpeed完成训练/推理。

常见问题

DeepSpeed支持的分布式AI训练有哪些类型?

DeepSpeed支持数据并行(Data Parallel)、模型并行(Model Parallel)、流水线并行(Pipeline Parallel)、张量并行(Tensor Parallel)、专家模型并行(Expert Parallel)等主流训练范式,协同ZeRO等创新算法,适用于从单机多卡到千卡集群的各种复杂场景,极大减少显存瓶颈。

- 更多ZeRO分布式说明见 官方培训技术页面。

如果预算有限,DeepSpeed是否也适合中小团队?

是的。DeepSpeed创新的内存管理和分布式策略能让中小团队利用市售单机服务器、云端中低配GPU实现以往只有“AI巨头”能完成的超大模型训练。并且其对CPU、NVMe等存储的异构优化,降低高配硬件投入门槛。部署参考 资源配置文档。

DeepSpeed对推理部署和模型压缩有什么帮助?

DeepSpeed-Inference和DeepSpeed-Compression可将百亿参数模型轻松“装下”8G及以上显存卡,并显著提升推理并发能力和速度。ZeroQuant等技术还能实现极低成本的W4A8等量化模型,方便边缘/低带宽场景部署。查看 推理技术页面 和 压缩功能 获取详细资料和开源工具。

随着大模型时代全面到来,DeepSpeed已成为AI训练模型的核心引擎。它的开源开放与极致性能,让从初学者到AI巨擘都能按需构建属于自己的智慧模型。无论你身处AI科研、工业落地还是云原生服务,DeepSpeed都是你探索AI边界、提升效率与控制成本的强力臂膀。立即前往DeepSpeed官网,开启AI训练的无限可能。

数据统计

数据评估

本站AI 喵导航提供的DeepSpeed都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI 喵导航实际控制,在2025年8月7日 上午11:53收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI 喵导航不承担任何责任。

相关导航

PaperBetter AI

Adobe Image Background Remover

绘蛙

羚珑

火龙果写作

易撰

AI Prompt Generator