rivos芯片凭借开放的RISC-V架构、Chiplet模块化设计和高能效AI加速能力,成为AI初创企业高效算力突破的热门选择。文章解析其针对于大模型训练、边缘推理、AIaaS等应用场景的技术创新,对比英伟达GPU等传统方案,突出其弹性配置、成本优化、生态兼容等多重优势,为AI初创企业提供算力升级新路径。

rivos芯片解决方案的行业背景与挑战

AI芯片赛道火爆,初创公司挑战重重

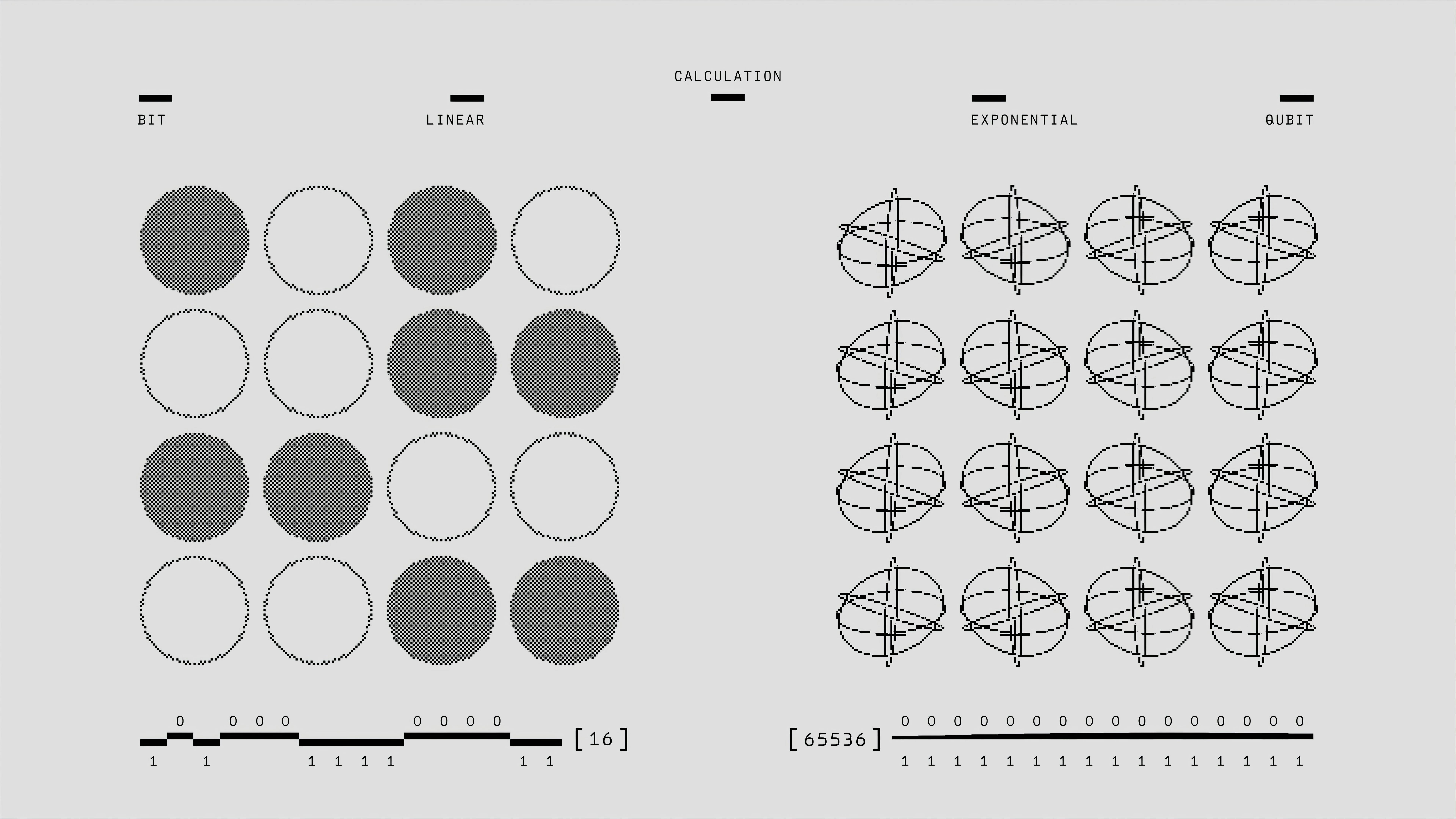

AI大模型时代的“算力焦虑”让芯片成为智能化基础链条的核心。英伟达等传统巨头长期垄断高性能AI芯片领域,全球80%以上的大模型训练和推理业务依赖其GPU。然而,算力昂贵、能效瓶颈、生态封闭等问题,令以rivos为代表的新晋玩家迎来高光时刻。

行业需求新变化

- 大模型/多模态AI训练量提升:模型参数量已从亿级跃升至千亿、万亿,AI芯片对I/O带宽、内存一致性和扩展能力的要求大幅提升。

- 开放计算与灵活性需求:企业和创新者渴望跳出“闭源软件+专用硬件”的生态,拥抱开放架构RISC-V带来的自主与可定制空间。

- 高能效及多场景适配:AI从云端走向边缘,除超算中心外,医疗、车载、智能终端等多场景同样渴求灵活、节能的AI芯片。

AI初创企业如何突破这些壁垒?rivos芯片方案给出了新答案。

rivos芯片技术解析与创新点

独特的RISC-V+定制加速架构方案

rivos公司专注于基于RISC-V指令集的高性能芯片设计。区别于传统GPU/ASIC,rivos采用“通用CPU+数据并行加速器”的异构算力架构,为AI提供按需弹性和裸金属级别的资源隔离。

- 高吞吐低延迟的RISC-V多核CPU:具备大规模并发调度能力和芯片级虚拟化。

- 面向AI/数据处理的自研加速器IP:针对深度学习计算优化,支持矩阵乘、张量操作、稀疏计算等大模型核心算子。

- Chiplet模块化设计:CPU、加速器、I/O控制分离,便于定制扩展和产能灵活部署。

突破英伟达生态壁垒的新思路

rivos不仅做硬件,还提供基于开源生态的端到端软件工具链,极大降低用户切换门槛。

- 完全开放RISC-V ISA、开放软硬件接口,支持Linux/Unix主流操作系统及KVM、Docker等云原生技术。

- 高效兼容主流AI框架(如TensorFlow、PyTorch),通过“代码自动转译+独立驱动库”方案兼容CUDA生态。

- 提供云数据中心到边缘设备全栈解决方案,用户可按业务需求自由部署在本地或多云环境。

友情链接:

– RISC-V官方社区

– TensorFlow

– PyTorch

能效与成本优势

- 支持先进工艺制程(7nm/5nm),在同等算力下能效比主流AI GPU提升可达30%以上。

- 模块化使初创公司按需采购,只为业务核心场景买单,大幅降低总拥有成本(TCO)。

rivos芯片在AI初创企业中的典型应用场景

数据中心AI推理与训练

多实例大模型/分布式训练——rivos平台的Chiplet架构和自研高速互连,在超大参数量模型的分布式算力调度、跨节点并行时优势明显。

- 提供裸金属体验,避免传统虚拟化下的资源争抢瓶颈。

- 弹性部署,支持“即插即用”调整算力规模,提升AI算力利用率。

智能边缘推理

智能云端网关、边缘推理终端——得益于高能效和定制AI加速器,rivos芯片适配各类边缘场景。

- 算力能耗比高于业界同类产品30%以上。

- 支持“硬件安全隔离”,适合多租户、数据隐私敏感型应用(如智慧城市/医疗设备)。

AI SaaS服务与AI开发平台

AI算力即服务(AIaaS)/AI云开发平台——初创企业可基于rivos平台自定义弹性AI算力池,灵活分发训练、推理、微服务等任务。

- 支持主流容器与微服务环境,实现高可用、多租户高效隔离。

- AI模型可一键迁移至云、边、端三个场景。

rivos芯片助力AI初创企业突破的关键价值

| 价值维度 | 具体表现 |

|---|---|

| 算力弹性 | 按需组合CPU、加速器,适配不同AI工作负载,实现训练、推理动态切换 |

| 开发灵活度 | 基于RISC-V开放架构,自主掌控IP与硬件定制能力 |

| 生态兼容 | 全面兼容主流AI开发框架,与英伟达CUDA软件生态高度互补,无缝代码迁移使用 |

| 成本优势 | 按需扩容,Chiplet模块化降低初期投入与长期维护成本 |

| 能效表现 | 低功耗高效率,对比传统AI芯片能效提升20%~35%,长期节省算力与运营费用 |

| 数据安全 | 内建多级安全隔离和硬件级加密机制,保障算力多租户环境下的数据合规 |

rivos方案对比主流AI芯片的竞争力分析

| 特性 | rivos | 英伟达GPU | 传统AI ASIC(如TPU) |

|---|---|---|---|

| 架构类型 | RISC-V+定制加速器/Chiplet | CUDA-GPU | 专用加速器(固定功能) |

| 开放性 | 极高,开源RISC-V/模块化设计 | 封闭,依赖其软件/硬件 | 封闭,生态壁垒强 |

| 算力弹性与配置 | 高,可客户级别灵活定制 | GPU固化配置,弹性有限 | 固化配置,定制困难 |

| 生态兼容 | 支持主流AI框架代码迁移 | 完全依赖CUDA生态 | 生态受限,需适配 |

| 能效/功耗 | 同等算力能效更优 | 能耗高 | 节能但灵活性与兼容差 |

| 成本结构 | 按需采购,初创投资门槛低 | 高昂单卡费用(每卡3-4万美元) | 量产成本低但初始投入高 |

| 数据安全与隔离 | 芯片级别硬件隔离,支持多租户使用 | 基于虚拟化,隔离有限 | 一般不支持多租户 |

rivos芯片工具链与AI开发者生态赋能

rivos开发者工具链全景

rivos不仅硬件开放,其软件工具链与开发支持也同步发力。官方目前主推的开发平台可对标英伟达CUDA Toolkit。

- 硬件抽象驱动包—提供编译优化、调试、性能分析工具,减少硬件迁移成本。

- AI算子优化库—针对Transformer、CNN等主流网络提供深度算子加速,兼容(PyTorch Extension/TensorFlow Plug-in)。

- 集成式模拟和性能分析框架—支持AI开发者提前做多场景跨平台评测,量化收益与功耗数据。

- 云端远程开发与测试环境—类似Google Colab、AWS SageMaker,开发者无需自建物理实验平台。

产业应用联合加速

rivos积极与芯片设计服务商、AI算法团队、本地ISV展开联合方案认证(如RISC-V国际基金会、Linux基金会等),合作伙伴包括英特尔、戴尔科技集团、Silicon Labs等,为开发者和初创企业提供端到端的商用快通道。

rivos芯片解决方案案例实践

实践案例1:AI大模型训练与推理云服务

- 某AI初创企业通过rivos平台推出多租户大模型推理API服务,相较传统GPU方案算力成本降低30%,代码迁移周期缩短50%。

- 利用Chiplet扩容能力,应对不同客户高峰业务无缝扩展,无需“买大卡”,支持自动定价。

实践案例2:智能医疗边缘算力

- 医疗AI影像初创公司用rivos边缘计算板卡,能保证CT/MRI多任务快速推理分析,单设备比传统国产AI芯片节能40%。

- 通过RISC-V内建加密机制,满足欧盟GDPR数据本地合规要求,数据不出医院。

实践案例3:AI芯片SaaS开发平台

- 某开发平台公司基于rivos芯片,打造“低代码AI模型开发-训练-部署”一体化链路,为AI初创企业提供即开即用的模型训练及推理、自动弹性扩容、账单灵活结算。

AI芯片创新趋势与rivos的未来展望

AI芯片创新技术大势

- 开放架构(如RISC-V)日益成为通用AI芯片主流,加速软硬一体创新。

- Chiplet模块化设计、数据并行加速器、存算一体等前沿技术融合,推动算力、能效突破极限。

- 多场景适配与工具链生态完善,决定AI初创企业能否实现“从想法到落地”的高效计算。

- 安全合规与AI治理需求提升,加快芯片安全隔离、多租户能力建设。

伴随全球AI初创企业的勃兴,算力需求持续升级。rivos芯片解决方案以开源开放的RISC-V架构、灵活的Chiplet高能效组合、软硬一体化生态赋能,正成为下一代AI算力创新的核心推动力之一。

随着全球AI产业迈入从数据中心到智能边缘、从英伟达主导到多元创新的时代,选择rivos等新型芯片平台,将为AI企业带来前所未有的成长空间与竞争力。智能未来,正在从“芯”启程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...