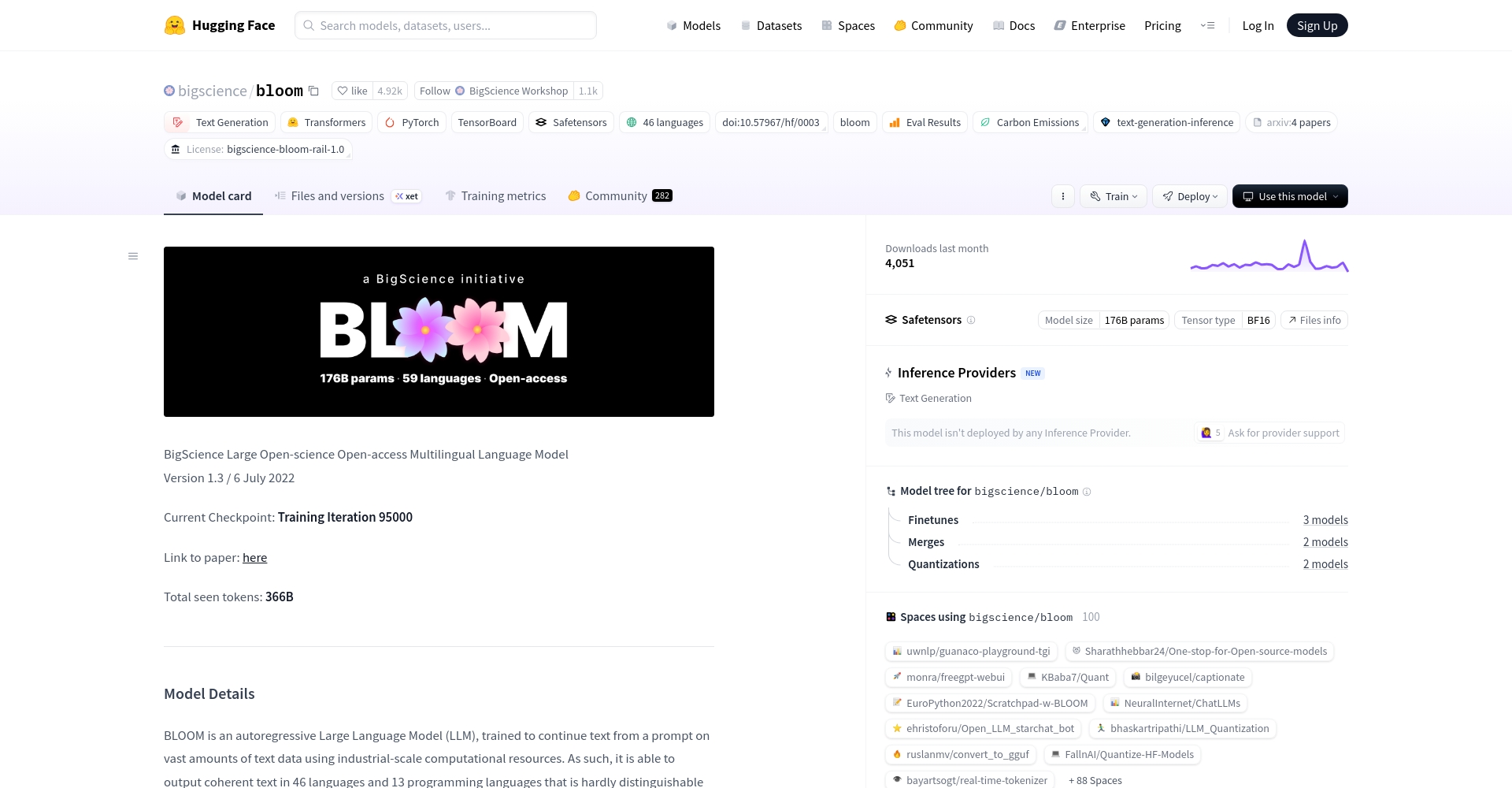

BLOOM:开启大规模多语种开源 AI 训练模型的新时代。BLOOM是由全球数百名AI研究者共同推出的生成式大型语言模型,具有超大规模参数、多语言覆盖和开放的特性,支持46种自然语言和13种编程语言。BLOOM的发布象征着AI研究的自由与开放,以其强大的生成能力和适用性为业界注目。

BLOOM的主要功能

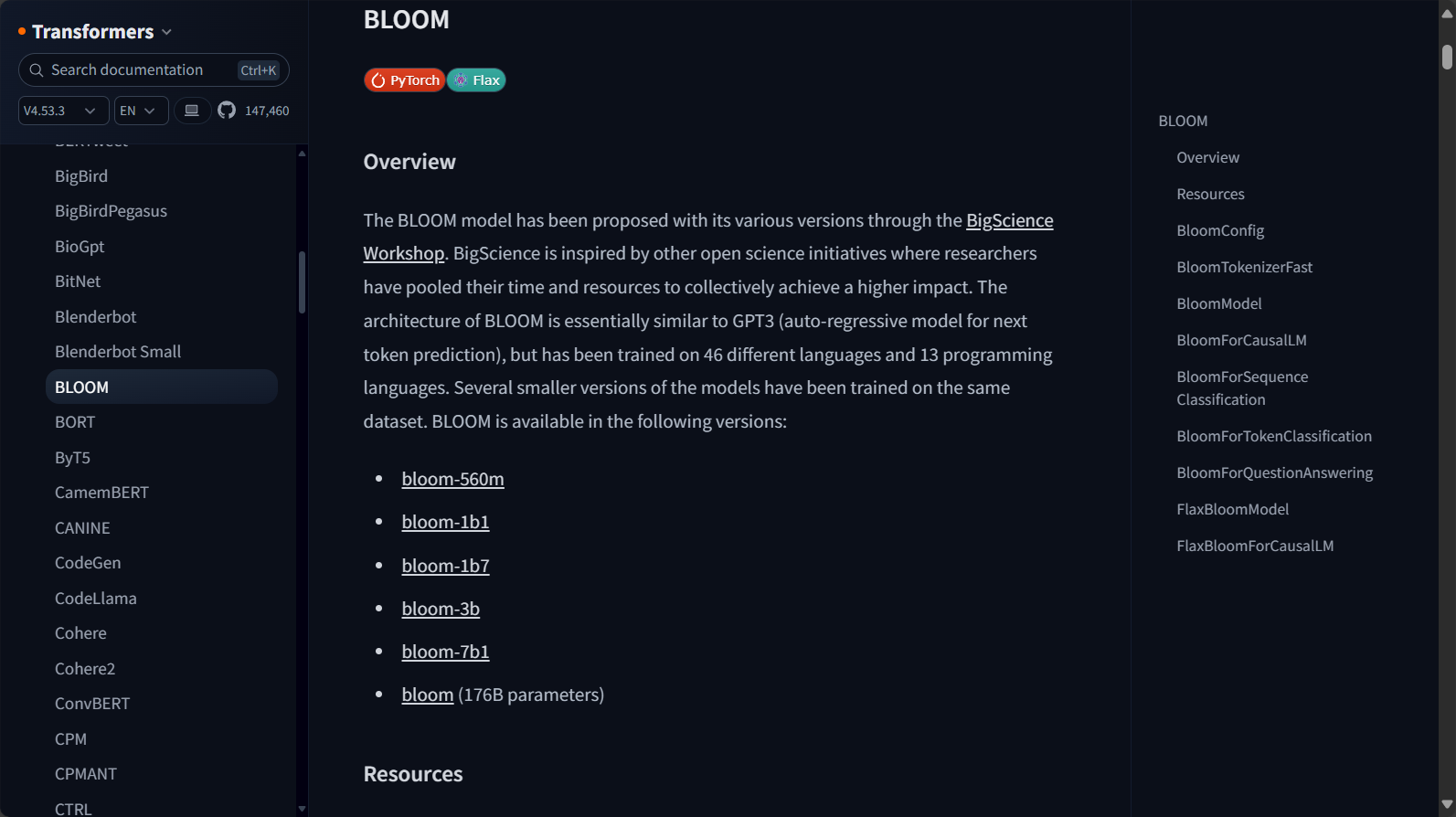

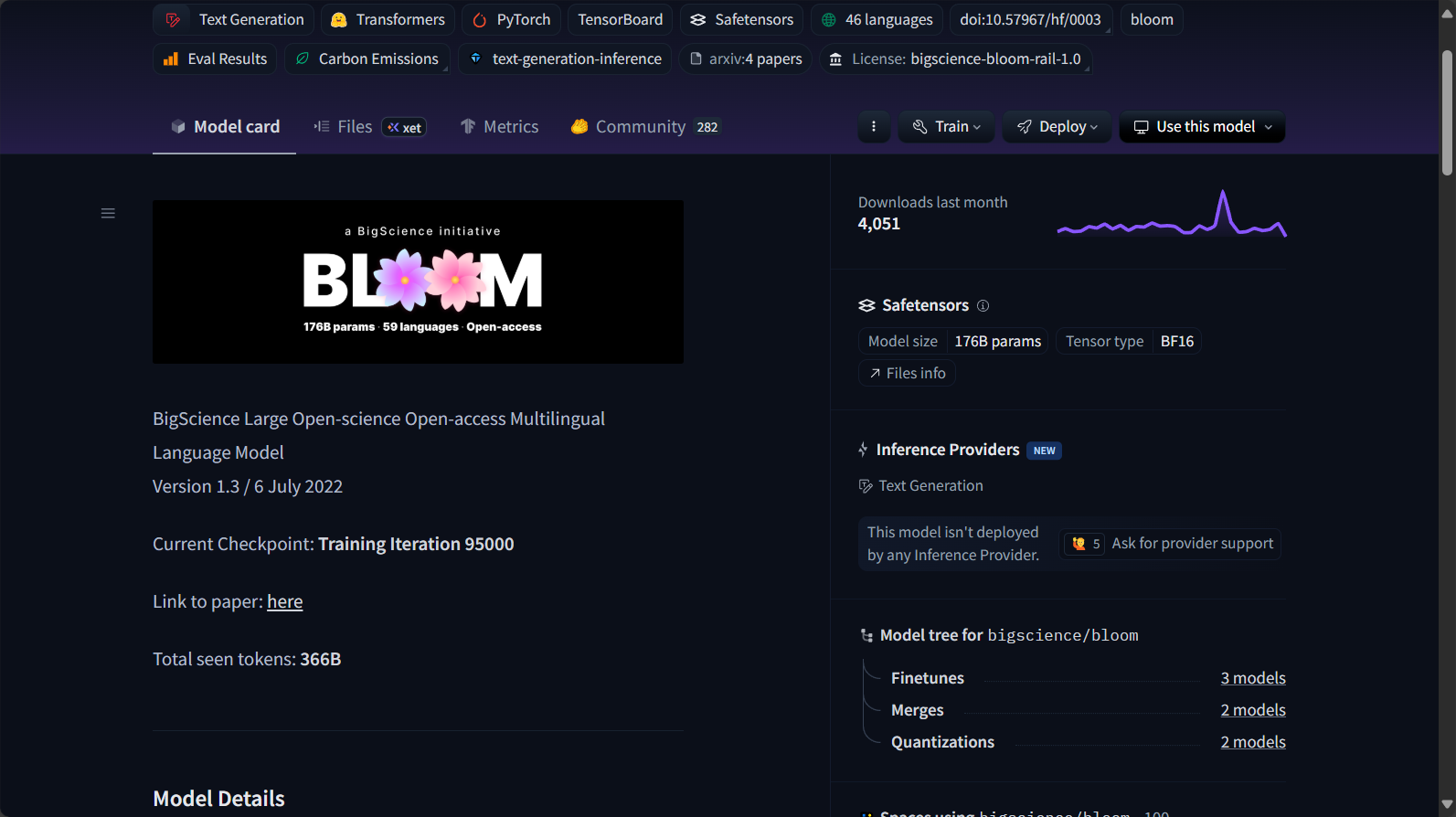

BLOOM是一个自回归生成式大型语言模型,采用transformer架构,拥有高达1760亿参数,支持46种自然语言和13种编程语言。该AI训练模型是由BigScience Workshop在法国Jean Zay超级计算机上开发训练,旨在推动透明、可复用、开放的AI研究生态。其优势体现在:

- 多语言支持:涵盖英语、法语、中文、印地语、阿拉伯语等。

- 强大生成能力:可根据用户提示生成连贯、类人的文本。

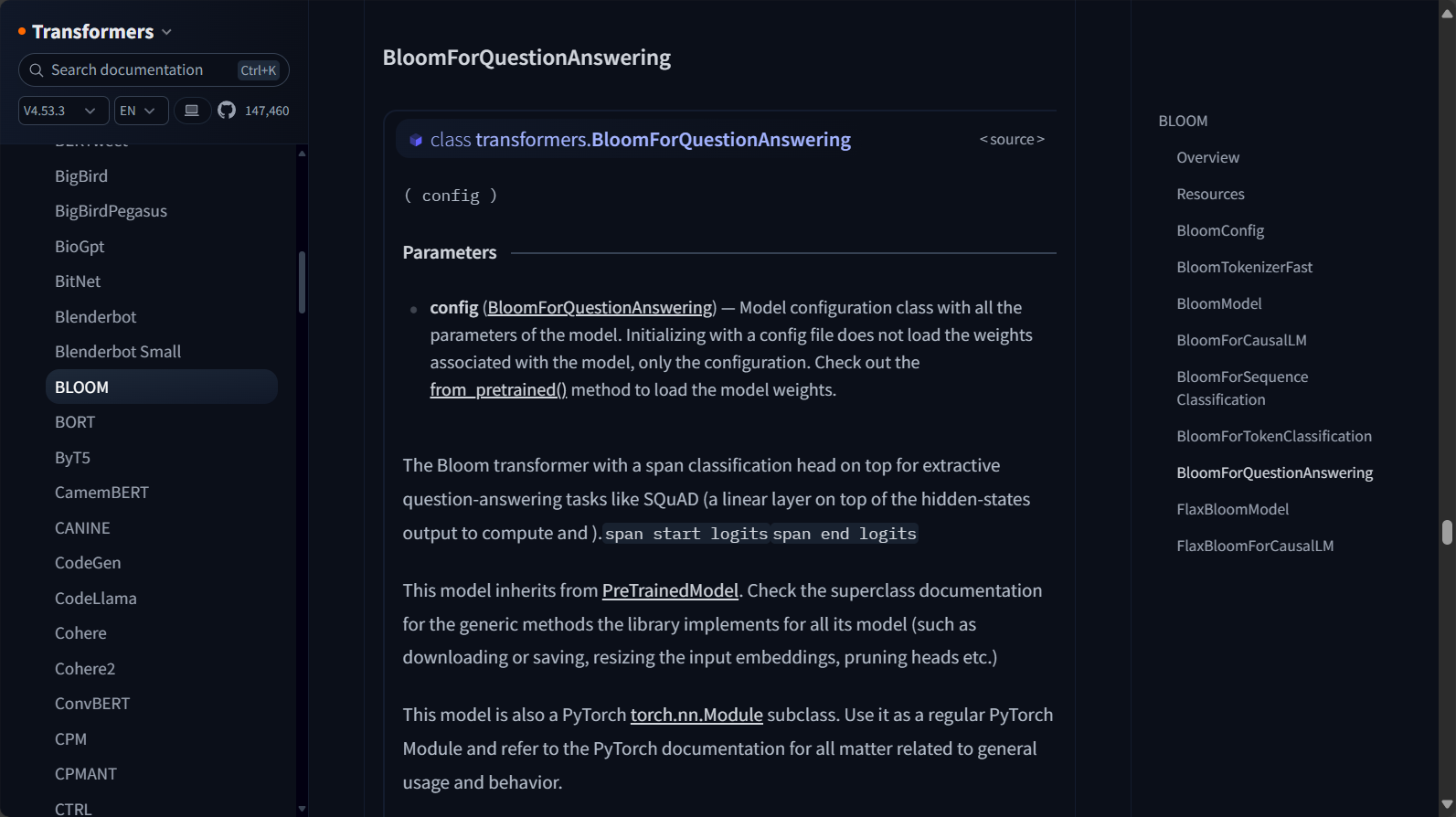

- 下游任务迁移:易于微调于摘要、问答、翻译、信息抽取等NLP任务。

- 编程语言兼容:对Python、Java、C++等主流编程语言有良好表现。

- 完全开源/可下载:任何人均可通过Hugging Face免费获取与部署。

例如,BLOOM能轻松实现如下功能(来源:功能页面链接):

| 功能类型 | 说明 |

|---|---|

| 文本生成 | 续写、对话、短文创作 |

| 摘要/信息抽取 | 自动生成文本摘要、提取关键信息 |

| 代码补全 | 多种编程语言的代码补全与生成 |

| 语义理解 | 某些形式下可处理阅读理解、问题回答 |

| 多语言翻译 | 支持多语言互译(非专业MT,但可做demo、实验) |

BLOOM的数据多样性统计

BLOOM在AI训练过程中采用了极其多元化的语料库,具体包括如下表格:

| 语言或类型 | 数量/比例 |

|---|---|

| 自然语言 | 46 |

| 编程语言 | 13 |

| 预处理文本规模 | 1.6 TB |

| 训练Token数 | 3500亿(350B) |

| 支持最大文本长度 | 2048 Token |

更多模型细节参见官方Hugging Face文档。

BLOOM的价格 & 方案

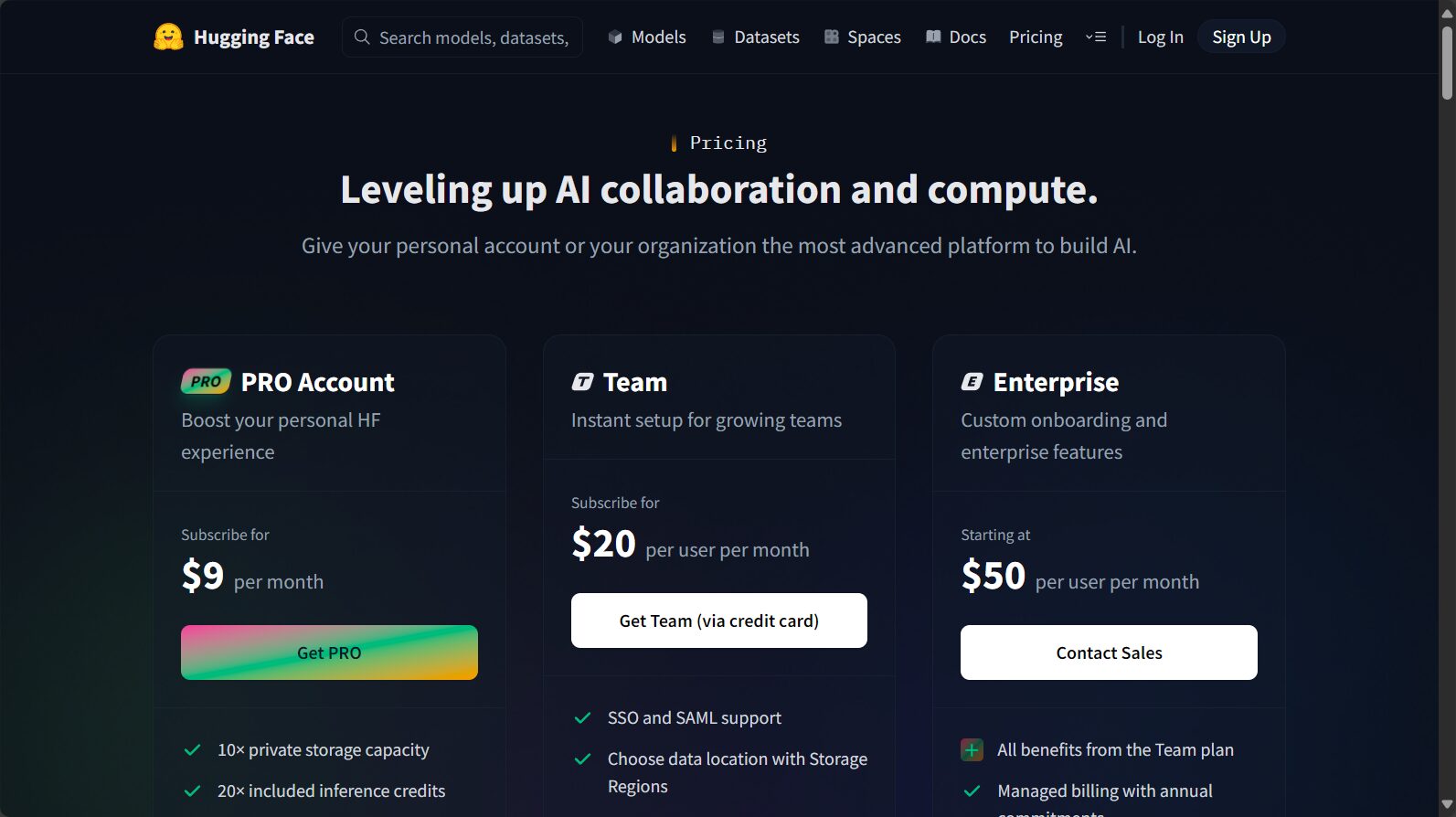

BLOOM作为开源模型,其基础模型完全免费,所有人都可通过Hugging Face下载和本地部署,无需支付任何许可费用。

BLOOM的发布遵循BigScience RAIL许可协议,允许个人、研究机构、社会团体免费使用和修改,但需明确不可用于违反伦理与法律的场景。如果使用云端推理服务、定制API或企业级部署,Hugging Face可能会另有付费方案,但这属于云厂商、平台方的增值服务,与BLOOM模型本身开源属性无冲突。

查阅更多价格和部署细节,可访问Hugging Face定价页。

如何使用BLOOM

BLOOM的设计强调“开箱即用”,支持多平台多框架调用。开发者可通过以下几种方式:

- 直接下载权重与tokenizer,在本地用PyTorch/Transformers加载使用。

- 通过Hugging Face接口直接云端推理(需注册和API密钥)。

- 支持微调(Fine-tune)/迁移学习,满足特定业务需求。

快速使用示例(参见官方快速上手文档):

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("bigscience/bloom")

model = AutoModelForCausalLM.from_pretrained("bigscience/bloom")

prompt = "请简要介绍BLOOM模型的主要功能。"

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))如果只需小规模尝试,Hugging Face Spaces中也有可交互的Web Demo。

硬件要求说明表:

| BLOOM参数规模 | 最佳硬件建议 |

|---|---|

| 176B参数全量版 | 多张A100 GPU/企业级服务器 |

| 7B/3B/1B版本等轻量版 | 单张高端GPU即可 |

BLOOM的适用人群

BLOOM定位“开源开放、技术前沿”,因而适合以下群体:

- 学术研究者和高校师生:可做NLP课题研究、结果复现、模型微调等。

- AI开发者与工程师:集成至产品原型、开展AI能力验证。

- 多语种应用开发商:服务于跨国企业或语言多样用户群。

- 数据科学家:用于特定语域、领域知识抽取、自定义任务。

- 开源社区贡献者:开展模型优化、评测、配套工具开发等。

- 编程教育与自动化工具开发者:实验AI代码生成/补完功能。

应用实例范围对照表:

| 应用类型 | 示范价值 |

|---|---|

| 多语言文档生成/摘要 | 自动合成多语种信息 |

| 问答、对话机器人 | 构建支持多种语言的助手 |

| 代码理解与补全 | 支持学科性编程辅助 |

| 跨语种内容创作 | 全球用户内容自动化 |

| 低资源语言研究 | 推动语言多样性保护 |

详细适用人群和操作建议,也可查阅官方说明文档。

BLOOM技术架构与AI训练模型亮点

模型架构特性

- 采用Decoder-only结构,类似GPT-3,但覆盖语言更多,具备更优的迁移与泛化能力。

- 参数量高达176B,支持序列长度2048 token,旨在实现更大范围的语义理解与生成。

| 架构参数汇总 | 配置/说明 |

|---|---|

| 层数 | 70 |

| 注意力头数 | 112 |

| 隐层维度 | 14336 |

| 词表大小 | 250,680 |

参考:更多技术详情

AI训练模型的多样性与公平性

- 数据覆盖广泛,包括46种自然语言、13种编程语言,1.6TB高质量文本。

- 强多样性设计原则,重视低资源语言的Proportional采样,强调“开源、开放、包容”。

- 模型版本多样,除176B参数全量版外,还提供7B1、3B等轻量版,便于资源有限用户使用。

BLOOM的风险、局限与使用建议

限制与风险需正视:

- 非高风险决策工具:模型内容“看似靠谱但真实准确性需核查”,不适用于生物医疗、金融、法律等场景直接决策。

- 可能输出有害内容:如带偏见、攻击性、敏感词汇等。

- 需严守伦理和数据合规:遵循RAIL协议,不得违规滥用。

| 主要风险类型 | 具体说明 |

|---|---|

| 观点偏倚/数据不均衡 | 部分群体信息出现频率不同 |

| 个人信息泄露 | 训练数据中或有敏感内容 |

| 错误信息产生 | 生成内容非100%事实 |

| 不当领域使用 | 禁止自动评测个体、关键判决场景 |

详见:风险与限制说明文档。

BLOOM常见问题

BLOOM模型有什么不同版本,它们如何选择?

BLOOM提供了从微小型(bloom-560m)到超大规模(bloom-176B)多种参数级别版本。

- 硬件资源有限推荐选择7B、3B等轻量版。

- 科研及高性能需求可选用176B全量版,但需分布式多卡部署。

详细版本一览表请见:BLOOM模型列表

BLOOM可以用在商业产品吗?

根据开源RAIL协议,BLOOM基本可用于商业应用(只要不违法、不用于高风险/违规场景),但建议详细阅读许可协议,确保不违反附加条款。如涉及云端API商业调用,还需按照Hugging Face平台额外条款付费。

BLOOM能否自定义微调?对自有数据好用吗?

BLOOM设计为可迁移/微调的AI训练模型,开发团队和社区已给出多种微调实操方案。基于公开Transformers工具包,开发者可在自有数据集上快速适配BLOOM用于分类、标注、生成等下游任务。

微调教程/实战:可参考官方文档及社区分享。

结尾

BLOOM已成为推动NLP民主化、AI开放协作的“里程碑”,其多语种能力与开放生态为全球开发者和AI训练模型爱好者创造了前所未有的创新土壤。无论是科研实验、语言多样性保护,还是智能产品原型开发,BLOOM都为你准备了灵活、专业、开放、高性能的AI新范式。如果你有兴趣体验尖端AI的力量,不妨即刻访问BLOOM官方文档开启你的探索之旅,共同推动AI科技的繁荣盛开。

数据统计

数据评估

本站AI 喵导航提供的BLOOM都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI 喵导航实际控制,在2025年7月26日 下午12:02收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI 喵导航不承担任何责任。

相关导航

悟道

PhotoMagic

巨日禄

Llama 3

DeepSeek

HitPaw Watermark Remover

有言